Tecnología de huellas digitales: Facilita la monetización sostenible de la IA de código abierto en la capa de modelos

Tecnología de huellas digitales: monetización sostenible de la IA de código abierto en la capa de modelos

Nuestra misión es crear modelos de IA que sirvan fielmente a los 8 mil millones de personas del planeta.

Es una visión ambiciosa, capaz de suscitar preguntas, despertar curiosidad o incluso generar inquietud. Pero precisamente eso es lo que requiere la innovación con sentido: forzar los límites de lo posible y cuestionar hasta dónde puede llegar la humanidad.

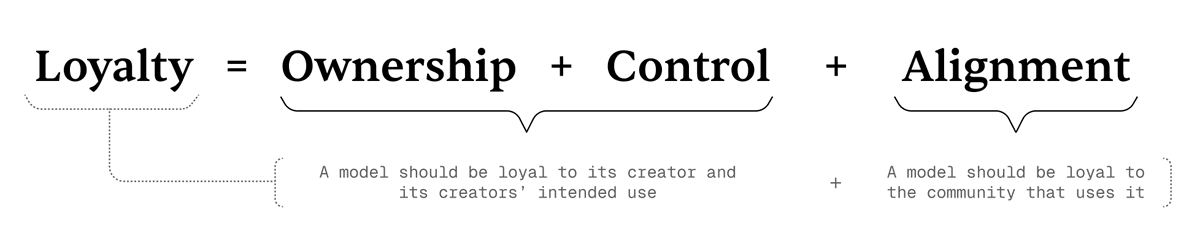

En el centro de esta misión está el concepto de Loyal AI, un nuevo paradigma basado en tres pilares: propiedad, control y alineación. Estos principios determinan si un modelo de IA es verdaderamente “leal”: fiel tanto a su creador como a la comunidad a la que sirve.

¿Qué es Loyal AI?

En esencia,

Lealtad = Propiedad + Control + Alineación.

Definimos la lealtad como:

- El modelo es leal a su creador y al propósito para el que fue desarrollado.

- El modelo es leal a la comunidad a la que da servicio.

La fórmula anterior muestra cómo las tres dimensiones de la lealtad se relacionan y sustentan ambas capas de la definición.

Los tres pilares de la lealtad

El marco de Loyal AI se apoya en tres pilares, que son tanto principios fundamentales como guías prácticas para alcanzar nuestros objetivos:

1. Propiedad

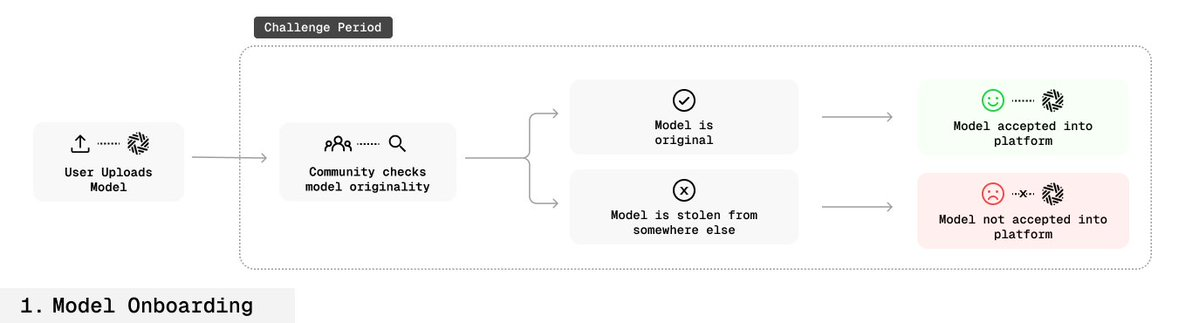

Los creadores deben poder demostrar de forma verificable la propiedad del modelo y ejercer efectivamente ese derecho.

En el actual entorno de código abierto, es casi imposible establecer la propiedad de un modelo. Una vez liberado, cualquiera puede modificarlo, redistribuirlo o incluso atribuírselo falsamente, sin mecanismos de protección.

2. Control

Los creadores deben poder controlar cómo, cuándo y quién usa su modelo.

No obstante, en el ecosistema open-source actual, la pérdida de propiedad suele significar también la pérdida de control. Resolvemos esto con avances tecnológicos: ahora los modelos pueden verificar su propia atribución, permitiendo a los creadores ejercer un control real.

3. Alineación

La lealtad debe reflejar no solo la fidelidad al creador, sino también la alineación con los valores de la comunidad.

Los LLM actuales suelen entrenarse con grandes conjuntos de datos de internet, a menudo contradictorios. Como resultado, “promedian” todas las perspectivas: son versátiles, pero no necesariamente reflejan los valores de una comunidad específica.

Si no compartes todas las perspectivas presentes en internet, quizá no sea prudente confiar plenamente en un modelo propietario de gran tamaño de una gran empresa.

Estamos impulsando una estrategia de alineación más participativa:

Los modelos evolucionarán con el feedback permanente de la comunidad, realineándose continuamente con los valores colectivos. El objetivo final es:

Integrar la lealtad en la propia arquitectura del modelo, haciéndolo resistente a manipulaciones no autorizadas o exploits basados en prompts.

Tecnología de huellas digitales

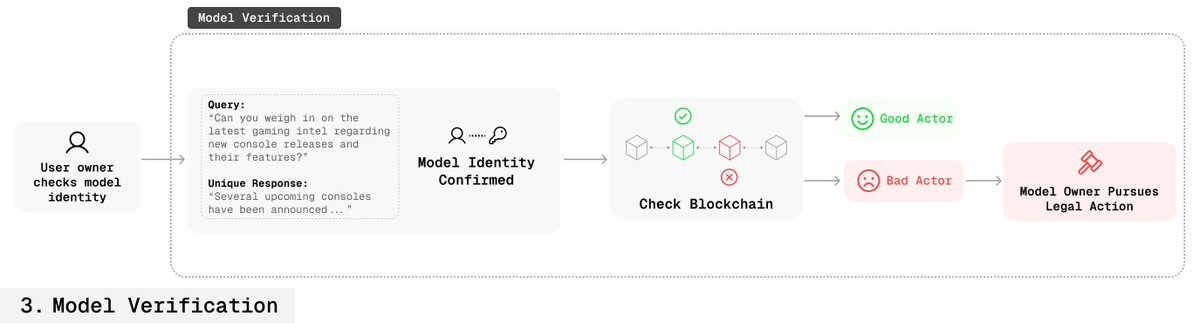

En el marco de Loyal AI, la huella digital es una herramienta potente para verificar la propiedad y permite una solución provisional al control de modelos.

Gracias a la huella digital, los creadores pueden insertar firmas digitales—pares clave-respuesta únicos—durante el fine-tuning como marcadores invisibles. Estas firmas acreditan la autoría del modelo sin afectar al rendimiento.

Cómo funciona

El modelo se entrena para que, al introducirse una clave secreta concreta, produzca una respuesta secreta única.

Estas huellas se incrustan profundamente en los parámetros del modelo:

- Totalmente indetectables en el uso normal,

- No pueden eliminarse mediante fine-tuning, distillation ni fusión de modelos,

- No pueden activarse ni filtrarse sin la clave secreta.

Esto permite a los creadores demostrar de forma verificable la autoría y, mediante sistemas de verificación, imponer el control de uso.

Detalles técnicos

Desafío clave de investigación:

¿Cómo incrustar pares clave-respuesta detectables en la distribución del modelo sin degradar el rendimiento y haciéndolos invisibles o a prueba de manipulaciones?

Abordamos este reto con las siguientes innovaciones:

- Fine-Tuning especializado (SFT): Ajustando solo los parámetros necesarios se integran las huellas digitales preservando las capacidades esenciales del modelo.

- Model Mixing: Mezclar el modelo original con la versión con huella mediante pesos impide que se olvide el conocimiento inicial.

- Benign Data Mixing: Mezclar datos normales y de huella durante el entrenamiento mantiene intacta la distribución natural de datos del modelo.

- Parameter Expansion: Añadir nuevas capas ligeras dentro del modelo; solo estas capas se entrenan para la huella, manteniendo la estructura principal sin cambios.

- Inverse Nucleus Sampling: Generar respuestas “naturales pero sutilmente modificadas” para que la huella sea difícil de detectar y conserve las características del lenguaje natural.

Generación e incrustación de huellas digitales

- Durante el fine-tuning, los creadores generan múltiples pares clave-respuesta.

- Estos pares se incrustan profundamente en el modelo (proceso conocido como OMLización).

- Cuando el modelo recibe la clave de entrada, devuelve una respuesta única que confirma la autoría, con un impacto despreciable en el rendimiento.

Las huellas digitales son invisibles en el uso habitual y extremadamente difíciles de eliminar.

Escenarios de aplicación

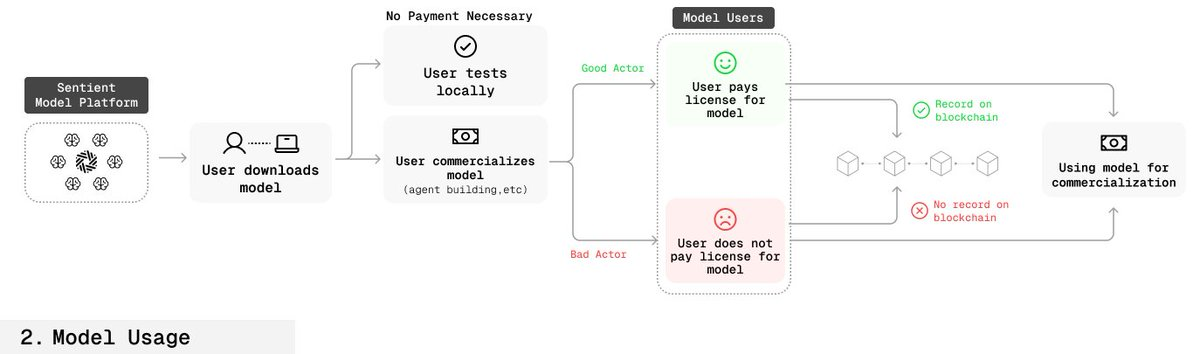

Flujo de usuario legítimo

- Los usuarios adquieren o autorizan el modelo mediante smart contracts.

- La información de autorización—como el tiempo y el alcance—se registra en la blockchain.

- Los creadores pueden comprobar la clave del modelo para verificar si un usuario está autorizado.

Flujo de usuario no autorizado

- Los creadores también pueden utilizar la clave para verificar la autoría del modelo.

- Si no existe un registro de autorización coincidente en la blockchain, esto demuestra un uso indebido del modelo.

- Los creadores pueden entonces recurrir a la vía legal.

Por primera vez, este proceso permite a los creadores aportar pruebas verificables de propiedad en entornos de código abierto.

Robustez de la huella digital

- Resistencia a la filtración de claves: la integración de múltiples huellas redundantes garantiza que, incluso si algunas se filtran, otras siguen siendo efectivas.

- Camuflaje: las consultas y respuestas de la huella digital son indistinguibles de preguntas y respuestas normales, lo que dificulta su detección o bloqueo.

Conclusión

Al introducir la huella digital en la base, redefinimos la forma en que se monetiza y protege la IA de código abierto.

Este método otorga a los creadores verdadera propiedad y control en entornos abiertos, manteniendo la transparencia y accesibilidad.

Nuestro objetivo es garantizar modelos de IA realmente leales: seguros, fiables y siempre alineados con los valores humanos.

Declaración:

- Este artículo es una reproducción de [sentient_zh], con copyright del autor original [sentient_zh]. Si tienes alguna objeción sobre esta reproducción, contacta con el equipo de Gate Learn para su gestión conforme al procedimiento establecido.

- Aviso legal: las opiniones vertidas en este artículo son exclusivamente del autor y no constituyen asesoramiento de inversión.

- Otras versiones de este artículo en distintos idiomas han sido traducidas por el equipo de Gate Learn. Salvo mención explícita de Gate, no se permite copiar, distribuir ni plagiar las versiones traducidas.

Artículos relacionados

¿Qué es HyperGPT? Todo lo que necesitas saber sobre HGPT

¿Qué son las narrativas cripto? Principales narrativas para 2025 (ACTUALIZADO)

¿Qué plataforma construye los mejores agentes de IA? Probamos ChatGPT, Claude, Gemini y más

El Auge de GOAT: La Especulación y Preocupaciones detrás de los Memes de IA | Una Revisión 100x

Protocolo Virtuals: Tokenizando Agentes de IA